Klar for å fråtse i data på nett fra 3000 meter under bakken? Det kan du faktisk, hvis du spesialist på undergrunnen og har omfavnet datavitenskap.

Er du i stand til å se og følge med på handlingen i to filmer samtidig? Sannsynligvis ikke så lenge. Hva med 10.000 Netflix-filmer per sekund? Selvfølgelig ikke – det er mer enn vår naturlige intelligens kan klare. På våre felt til havs produserer vi slike mengder data fra våre operasjoner hver dag, hele dagen. Nå vender ingeniører, geologer og geofysikere seg til datavitenskap for å få enda mer ut av undergrunnen.

Taber Hersum er geolog, og har nå også videreutdannet seg til datavitenskapsmann (eng. data scientist). Han kan “fråtse” i både dette og andre enorme datasett, som genereres med ny teknologi og datasensorer i virksomheten vår, og få noe fornuftig ut av det.

Equinor har plassert fiberoptiske kabler langs brønnene på det enorme Johans Sverdrup-feltet i Nordsjøen, faktisk akkurat den samme typen kabel som gir deg internett hjemme. Selv om det er lite behov for Netflix nede i et reservoar, er det behov for data, og det er dette som er årsaken til at vi bruker disse kablene. Med mindre endringer fungerer fiberkablene nå som mikrofoner og temperatursensorer som skaper enorme mengder data.

– Jeg har fått øynene opp for databaserte tilnærminger. Det er utrolig spennende, siden vi kan få innsikt i komplekse sammenhenger som ville vært umulig å forstå uten datavitenskap, sier Taber. Han leder fiberoptikk-prosjektet.

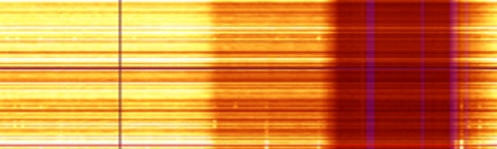

Fiberoptiske data vist i fo.tone, et visualiseringsverktøy utviklet av Equinor.

Bedre boreplanlegging med AIM

Det er ikke bare boreoperasjoner og overvåking som endres som følge av ny digital teknologi og datavitenskap. Arbeidet som gjøres før boringen begynner, altså i boreplanleggingsfasen, har også endret seg radikalt ved hjelp av kunstig intelligens. Et prosjekt som kalles AIM – ArtificialIntelligenceMaturation – endrer brønnplanleggingen fra en flere måneder lang og vanskelig manuell prosess for en boreoperasjon til feltutviklingsscenarioer med tusenvis av brønnalternativer. Med AIM kan vi autogenerere brønnbaner, og få forslag til optimale løsninger fra programvaren. Deretter kan vi bruke spesialistenes naturlige intelligens for å velgedet beste alternativet, basert på hva den kunstige intelligensen har foreslått. Det er fortsatt eksperten som er best til å tolke, men datamaskinen kan øke datadekningen, bygge nye prognosemodeller og bidra til å validere konsepter og ideer bedre og raskere enn før.

– Det handler om å kunne jobbe med valgmuligheter. Hvis vi kan få en bedre beskrivelse av kompleksiteten i brønnplanleggingen, inkludert tilgjengelige brønnslisser, boremål, og alle begrensningene, betyr det verdiskaping og effektiv bruk av vår tid. Å jobbe med AIM betyr for meg å jobbe på tvers av undergrunn og utfordringer knyttet til boring og brønn – jeg må forstå data og kunnskap på begge områder for å finne de billigste og minst risikable brønnbanene.

Før brønnplanlegging og boring trenger vi seismiske data. Og vi har faktisk allerede 50 petabyte med slike data fra hele verden. Det er mer enn det dobbelte av alt digitalt innhold i US Library of Congress, som er verdens største bibliotek. Vi jobber nå med å standardisere dataene våre og gjøre dem lett tilgjengelige via skyen. Når historiske data kombineres med nyere data, kan geologiske forhold fra ulike geografiske områder analyseres og sammenlignes for å se etter mønster og potensial. Når geologen kan bruke programvare til å analysere enorme mengder data som det ville ta flere år å gå gjennom manuelt, endrer det alt.

Renaud Laurain er geofysiker, og har også har videreutdannet seg innenfor datavitenskap. Han har jobbet i flere prosjekter som automatiserer det seismiske arbeidet:

– Det å gå fra innsamling av seismiske data til analyse av data har gitt meg et helt annet syn på betydningen av data i den moderne verden. Her er ett eksempel: Tidligere har arbeidsprosessene våre handlet om å redusere datamengden, slik at den kan være mulig å håndtere for et menneske.

Dataanalyse og maskinlæring endrer på alt det – og flytter fokus over på hvordan vi kan utnytte hele datamengden, forklarer han.